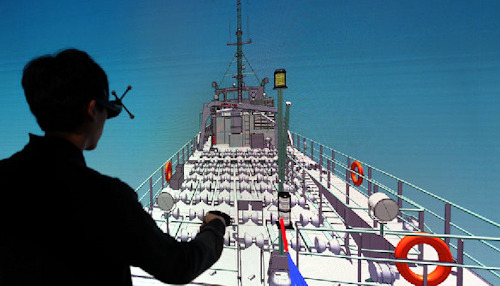

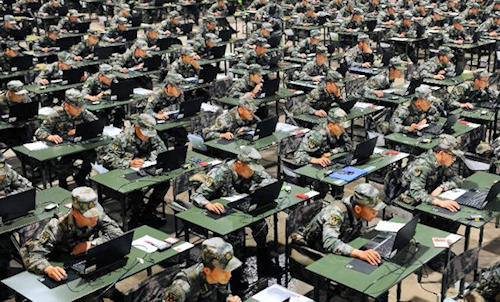

L’umanità è entrata in una nuova era dell’evoluzione che promette di cambiare le nostre vite, pochi se ne stanno rendendo conto. Tra loro vi è Klaus Schwab, fondatore e attuale direttore esecutivo del World Economic Forum, il “Forum di Davos”, che vi ha dedicato un libro dal titolo indicativo “La 4° rivoluzione industriale” nel quale descrive il salto che abbiamo compiuto con l’intelligenza artificiale (AI). Viviamo, sostiene infatti Schwab, un momento epocale, di quelli che si studiano sui libri di storia, paragonabile alla scoperta del Nuovo Mondo nel 1492. L’AI, in letteratura, viene indicata come “general purpose tecnology” (GPT), una tecnologia in grado di, come spiega Erik Brynjolfsson del MIT di Boston, “interrompere e accelerare la marcia del progresso economico”. Era già successo altre tre volte: con il vapore, che aveva dato inizio alla prima rivoluzione industriale (1760-1830), con l’elettricità (1870 -1945) che favorì la seconda, e in ultimo con la digitalizzazione negli anni 80-90. Vi è però una differenza sostanziale, che distingue le precedenti rivoluzioni da quella attuale. Durante le prime tre, l’introduzione di nuove tecnologie aveva modificato, ognuna a modo proprio, il ciclo di produzione, scomponendolo in più parti affidate a macchinari distinti, ma sempre creando nuove figure professionali con cui assorbire la forza lavoro eccedente. Così era successo nel XIX secolo con il trasferimento di ampie masse di lavoratori dalle campagne alla fabbriche, e analogo fenomeno si era osservato nei decenni successivi, sino agli anni 80-90 del secolo scorso (anche se l’avvento dei computer iniziò a ridurre progressivamente la creazione di nuovi posti di lavoro). In altre parole, in passato l’adozione di nuove tecnologie GPT costantemente "sottraeva" all’uomo capacità produttiva diretta, richiedendo però la sua presenza in alcune fasi della lavorazione e come supervisore dell’intero ciclo di produzione. Il contrario di quello che accade oggi con la AI, che opera essenzialmente nel campo “cognitivo”, quello che più ci caratterizza tra le specie viventi. La disponibilità di computer con enormi capacità di calcolo e la continua produzione di Big Data (il 90% dei dati disponibili sono stati creati solo negli ultimi due anni), hanno ampliato a dismisura lo sviluppo della AI, al punto che le macchine già superano l’abilità umana in moltissimi campi, dal riconoscimento vocale alla traduzione simultanea, dal riconoscimento facciale alla analisi di dati e di immagini, e la lista potrebbe ancora continuare. Dalla prima vittoria di un calcolatore, Deep Blue di IBM, contro il campione del mondo di scacchi, Garry Kasparov, nel lontano 1996 (il russo vinse tre incontri e ne pareggiò due, battendo infine la macchina con un risultato di 4-2), di strada ne è stata fatta. Nel febbraio 2011, sempre la IBM fece partecipare il sistema Watson a tre puntate del quiz televisivo statunitense Jeopardy!, durante le quali sconfisse ripetutamente il campione in carica. Il calcolatore, in grado di rispondere a domande espresse in linguaggio naturale, non era connesso a Internet, aveva accesso a 200 milioni di pagine di contenuti e al testo completo di Wikipedia, per un totale di 4 terabytes di spazio disco. È un’altra, però, la vittoria che ha maggiormente segnato il nostro tempo: quella che il calcolatore AlphaGO ha ottenuto nel maggio 2017 contro il campione del mondo di Go, il gioco cinese che contempla una quantità di combinazioni infinita. Il sistema sviluppato da Deep Mind (società di Google) riuscì a battere il campione in carica, Ke Jle, per tre volte consecutive, convincendo Pechino - come spiega l’ex CEO di Google China, Kai Fu Lee, nel suo ultimo libro -, ad accelerare il passo nello sviluppo e implementazione della AI. Bastano solo questi esempi per comprendere come la rivoluzione in atto prometta di svilupparsi a una velocità e ampiezza mai conosciute prima, investendo tutti i campi della produzione di beni e di servizi. In campo medico, radiologia e dermatologia sono solo alcune delle discipline in cui AI trova già piena applicazione. Il sistema Watson, dopo Jeopardy!, è stato adottato dal MD Andersen Cancer Center dell’Università del Texas, il più avanzato centro oncologico al mondo, dove analizza referti e pronuncia diagnosi basandosi su un database (sempre in aggiornamento) di milioni di casi clinici (in confronto, anche il più bravo dei medici può solo basarsi sulla sua, comunque limitata, preparazione). Anche in numerose realtà del campo legale, assicurativo e bancario si usano da tempo sistemi dotati di AI per valutare i dati prodotti da agenzie pubbliche e private al fine di suggerire in tempo reale il profilo di un cliente, la sua solvibilità e capacità di spesa. Il giornalismo sarà, tra le professioni, quella destinata a scomparire più rapidamente? Sono ormai numerose le testate on-line che si affidano ad algoritmi in grado di selezionare le notizie più battute e tradurle in articoli con una prosa e una forza narrativa pari a quella umana. Un esempio fra tutti: il Dow Jones, la più importante fonte di informazioni economiche al mondo, si basa su un sistema di AI in grado di elaborare giornalmente 1,5 milioni di articoli per consegnare agli utenti finali le informazioni e i metadati utili per le operazioni di borsa. Anche in campo militare, l’AI è destinata a cambiare gli scenari di riferimento. Lo spiega il gen. John R. Allen, già comandante di ISAF e attuale presidente della Brookings Institution su un articolo pubblicato lo scorso 27 dicembre sul sito di ISPI. Allen è convinto che “l’IA porterà a una nuova era di guerra in cui i processi di decisione e azione saranno significativamente più rapidi di qualsiasi cosa abbiamo visto prima”; una iperguerra nella quale “l’essere umano sarà rimosso dai processi di analisi dell’ambiente, e avrà un controllo meno diretto sugli eventi”. Rimanendo in tema, questa testata ha più volte illustrato i progetti di Pechino, nel campo della AI. Ma a quali pericoli andremo incontro se il trend accennato di progressiva implementazione della AI dovesse continuare ai ritmi conosciuti sino a oggi. Innanzitutto rischi di natura etica, presenti ad esempio nel dominio militare, essenzialmente legati alla possibilità che una “macchina intelligente” possa decidere della vita di essere umani. Una eventualità che in campo cinese non desta particolari opposizioni (Pechino teorizza a livello tattico l’impiego di sistemi “autonomi” di C2 dotati di AI). Vi sono poi pericoli in campo economico e sociale. Alcune fonti, tra quelle da me citate, stimano negli USA in circa il 40% il numero di posti di lavoro a rischio di automazione entro il 2030. Una valutazione che sullo sfondo minaccia il sorgere di una società caratterizzata da una progressiva disoccupazione di colletti blu e bianchi. È in gioco l’affermazione di un sistema economico non più incentrato sulle fabbriche tradizionali, ma su poche, enormi “piattaforme” che opereranno a livello globale - tipo Amazon - creando profitti immensi dalla vendita di merci e servizi prodotti da terzi. Una realtà in cui i siti di produzione sarebbero caratterizzati da cicli completamente robotizzati e intelligenti con una limitata presenza umana; in cui la crescente disponibilità di un mercato produttivo smisurato (chi produce i beni) e la graduale introduzione di stampanti a 3D (in grado di produrre oggetti basandosi esclusivamente su algoritmi di modellazione) spingerebbe sempre più al ribasso il costo della produzione, accentuando la disparità di profitto tra chi produce il bene e chi lo distribuisce sul mercato. Un mondo nel quale il lavoro (umano) contribuirebbe sempre meno alla produzione del profitto a tutto vantaggio del capitale, con crescente disparità sociale e enormi problemi di ordine pubblico. Non a caso sono sempre di più, e tra questi i principali guru della Silicon Valley, Mark Zuckerberg in testa, quelli che teorizzano un reddito universale di cittadinanza (i consumatori, d’altronde, sono pur sempre necessari). Ma sarebbe un altro il pericolo più temibile nell’ipotesi di uno sviluppo smisurato di AI: che “le macchine” - per dirla come Jerry Kaplan, massimo esperto del settore - “diventino un giorno sufficientemente intelligenti da programmarsi e migliorarsi fino al punto da rendersi indipendenti”. La chiamano “Singolarità”, e a quel punto saremmo già entrati in una nuova era, post umana, ma speriamo che siano gli scrittori di fantascienza i soli a dovercela descrivere.

Fonte, link e note: http://www.difesaonline.it